Informacje o artykule

DOI: https://www.doi.org/10.15219/em66.1260

W wersji drukowanej czasopisma artykuł znajduje się na s. 13-25.

Pobierz artykuł w wersji PDF

Pobierz artykuł w wersji PDF

Jak cytować

E-mentor nr 4 (66) / 2016

Spis treści artykułu

- Wprowadzenie

- Metody oceny jakości nauczania stosowane na przykładowych polskich uczelniach

- Organizacja przedmiotu poddanego analizie

- Cel badań

- Propozycja podejścia do oceny jakości realizacji procesu nauczania przez nauczyciela

- Przykład zastosowania proponowanej metody oceny jakości pracy nauczyciela - semestr letni roku akademickiego 2012/2013

- Podsumowanie

- Bibliografia

Informacje o autorach

Przypisy

1 M. Cieciora, Zarządzanie jakością procesu dydaktycznego w szkole wyższej, Wydawnictwo PJWSTK, Warszawa 2015; P. Grudowski, K. Lewandowski, Pojęcie jakości kształcenia i uwarunkowania jej kwantyfikacji w uczelniach wyższych, "Zarządzanie i finanse" 2012, R. 10, nr 3, s. 394-403; E. Stemposz, A. Stasiecka, A. Jodłowski, The Analysis of Some Factors Influencing the Quality of Teaching Processes, [w:] Computing in Science and Technology 2013, Monographs in Applied Informatics, Warszawa 2013/2014, s. 87-98.

2 I. Bąk, K. Wawrzyniak, Ocena jakości nauczania przedmiotów ekonomicznych na przykładzie Wydziału Ekonomicznego Zachodniopomorskiego Uniwersytetu Technologicznego w Szczecinie, http://repozytorium.uni.lodz.pl:8080/xmlui/handle/11089/5572, [30.11.2015].

3 E. Stemposz, A. Jodłowski, A. Stasiecka, Zarys metodyki wspierającej naukę projektowania systemów informacyjnych, Wydawnictwo PJWSTK, Warszawa 2013.

4 Studencka ankieta oceny zajęć dydaktycznych, Politechnika Warszawska, https://www.bip.pw.edu.pl/content/download/626/3885/file/33_z1.pdf, [15.04.2016]; studencka ankieta oceny zajęć dydaktycznych, Uniwersytet Warszawski, http://www.pejk.uw.edu.pl/?p=921, [15.04.2016]; studencka ankieta oceny zajęć dydaktycznych, SGGW, http://jakoscksztalcenia.sggw.pl/?page_id=35, [15.04.2016]; studencka ankieta oceny zajęć dydaktycznych, Uniwersytet Pedagogiczny w Krakowie, http://www.wp.up.krakow.pl/?page=dokumenty&subpage=dlapracownikow, [15.04.2016]; studencka ankieta oceny zajęć dydaktycznych, Uniwersytet w Białymstoku, http://www.hist-soc.uwb.edu.pl/o-wydziale/8-wydzial/124-ankieta-ewaluacyjna-sem-zimowy-r-a-2012-2013, [15.04.2016]; studencka ankieta oceny zajęć dydaktycznych, Zachodniopomorski Uniwersytet Technologiczny w Szczecinie, http://www.wbia.zut.edu.pl/fileadmin/pliki/wbia/zalaczniki/jakosc_ksztalcenia/przepisy/wzory_ankiet_ZUT_-_2013.pdf, [15.04.2016].

5 Na UwB wprowadzono elektroniczne ankiety, Kurier Poranny, 2012, http://www.poranny.pl/wiadomosci/bialystok/art/5464232,na-uwb-wprowadzono-elektroniczne-ankiety,id,t.html, [15.04.2016].

6 E. Stemposz, A. Stasiecka, A. Jodłowski, The Analysis..., dz.cyt.; I. Bąk, K. Wawrzyniak, dz.cyt.

7 S.M. Allesi, S.R. Trollip, Multimedia for learning: Methods and development, Allyn and Bacon, Needham Heights 2001.

8 Perspektywa uczenia się przez całe życie, Załącznik 4: Słownik pojęć polityki na rzecz uczenia się przez całe życie, http://bip.men.gov.pl/wp-content/uploads/sites/2/2011/06/plll_projekt28czerwca.pdf, [30.11.2015].

9 Krajowe Ramy Kwalifikacji uczenia się przez całe życie, http://www.nauka.gov.pl/krajowe-ramy-kwalifikacji-szkolnictwo/, [30.11.2015].

10 M.C. Paulk, et al., Capability Maturity Model for Software, CMU/SEI-91-TR-24, Carnegie Mellon University, Software Engineering Institute, Pittsburgh 1991.

11 J. Podgórski, Statystyka od podstaw, Państwowe Wydawnictwo Ekonomiczne, Warszawa, 1992.

12 Współczynnik zmienności CV(X) jest wyliczany zgodnie ze wzorem: CV(X) = σ(X) / E(X).

13 T. Kowalczyk, E. Pleszczyńska, F. Ruland (eds.), Grade Models and Methods for Data Analysis, With Applications for the Analysis of Data Populations, Springer Verlag, Berlin-Heidelberg-New York 2004.

14 GradeStat, Program for Grade Data Analysis, http://gradestat.ipipan.waw.pl/, [30.11.2015].

15 J. Książyk, O. Matyja, E. Pleszczyńska, M. Wiech (red.), Analiza danych medycznych i demograficznych przy użyciu programu GradeStat, Instytut Podstaw Informatyki Polskiej Akademii Nauk, Instytut "Pomnik - Centrum Zdrowia Dziecka", Warszawa 2005.

Propozycja podejścia do oceny jakości pracy nauczyciela w procesie edukacyjnym - studium przypadku

Ewa Stemposz, Andrzej Jodłowski, Alina Stasiecka

Wprowadzenie

Artykuł przedstawia studium przypadku oszacowania jakości pracy nauczyciela akademickiego w oparciu o analizę średnich ocen uzyskanych przez grupy studenckie dla egzaminu z określonego przedmiotu. Zaproponowane podejście uwzględnia charakterystykę roku, charakterystyki poszczególnych grup wchodzących w skład danego roku (w oparciu o średnią ze studiów dla grupy traktowanej jako całość), a także zajmuje się analizą wpływu oceny uzyskanej przez studenta zarówno na jego średnią ze studiów, jak i na średnią ocenę ze studiów dla grupy, której był członkiem. Badania oparto na podstawowej statystycznej analizie danych, a także analizie gradacyjnej.

Jednym z kluczowych zagadnień związanych z edukacją jest jakość nauczania1. W nauczaniu tradycyjnym zasadniczy wpływ na przebieg tego procesu ma osoba ucząca, a efekty nauczania są ściśle związane z jakością pracy nauczyciela2. Prace badawcze autorów niniejszego artykułu koncentrują się na określeniu sposobów pomiaru tej jakości i były prowadzone dla przedmiotu związanego z problematyką inżynierii oprogramowania - Projektowanie systemów informacyjnych z wykorzystaniem języka UML3, który jest wykładany w Polsko-Japońskiej Akademii Technik Komputerowych. Projektowanie należy do grupy tzw. umiejętności miękkich, w związku z czym nauczanie jest w tym przypadku zadaniem szczególnie trudnym i jakość pracy nauczyciela jest tu nie do przecenienia.

Metody oceny jakości nauczania stosowane na przykładowych polskich uczelniach

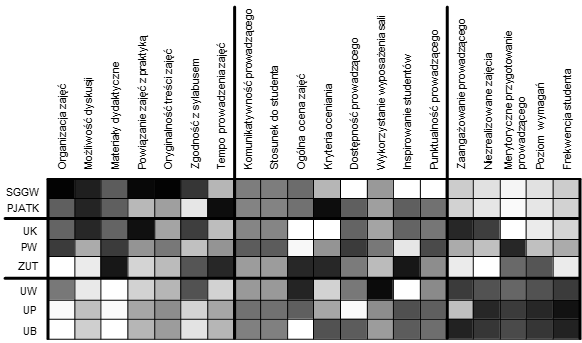

Autorzy artykułu przeprowadzili analizę porównawczą metod oceniania jakości realizacji procesu nauczania, które są wykorzystywane na polskich uczelniach, zarówno publicznych, jak i niepublicznych: Polsko-Japońskiej Akademii Technik Komputerowych w Warszawie (PJATK), Politechnice Warszawskiej (PW), Uniwersytecie Warszawskim (UW), Szkole Głównej Gospodarstwa Wiejskiego w Warszawie (SGGW), Zachodniopomorskim Uniwersytecie Technologicznym w Szczecinie (ZUT), Uniwersytecie w Białymstoku (UB), Uniwersytecie Jana Kochanowskiego w Kielcach (UK) oraz Uniwersytecie Pedagogicznym im. Komisji Edukacji Narodowej w Krakowie (UP).

We wszystkich analizowanych uczelniach podstawowym i często jedynym narzędziem używanym do oceny jakości pracy nauczyciela akademickiego są anonimowe ankiety4, za pomocą których studenci wyrażają swoją opinię o dydaktykach i prowadzonych przez nich zajęciach w danym semestrze lub roku (odrębnie dla każdego). Na niektórych uczelniach ankiety są przeprowadzane w formie papierowej i wypełniane przez studentów w trakcie zajęć (jak np. na UW). Najczęściej wykorzystywane są jednak ankiety w wersji elektronicznej, przy czym wypełnia je niewielki procent uprawnionych respondentów. W przypadku ankiet w wersji papierowej odsetek ten jest znacznie większy.

Ankiety studenckie mają postać krótkich kwestionariuszy zawierających od kilku do kilkunastu pytań zamkniętych (przykładowo: Czy to były zajęcia, na które chciałeś zapisać się w pierwszej kolejności?; Czy poziom wymagań stawianych studentom jest wysoki?; W jakim stopniu wykładowca sprawiedliwie ocenia studentów?) oraz jedno lub dwa pytania otwarte, jak np.: Uwagi, komentarze, dotyczące zrealizowanego kursu czy Propozycje, sugestie, dotyczące ewentualnych zmian. Wgląd w wyniki ankiet mają nauczyciele akademiccy podlegający ocenie oraz ich przełożeni.

Autorzy artykułu zebrali w sumie 98 pytań zamkniętych, zawartych w ankietach wymienionych uczelni, wśród których wyróżniono dwadzieścia grup pytań o zbliżonej treści. Każda z grup została skojarzona z pewną cechą. Zbiór 20 grup stanowił podstawę do przeprowadzenia analizy gradacyjnej z wykorzystaniem mapy nadreprezentacji programu GradeStat (patrz dodatek - mapa nadreprezentacji). Poniżej przedstawiono uporządkowaną alfabetycznie listę zidentyfikowanych cech:

- Dostępność prowadzącego (dostępność prowadzącego poza zajęciami);

- Frekwencja studenta (informacja o frekwencji studenta na zajęciach);

- Inspirowanie studentów (stopień inspirowania studentów do samodzielnego myślenia);

- Komunikatywność prowadzącego (stopień zrozumienia treści przekazywanych przez prowadzącego);

- Kryteria oceniania (obiektywność i przestrzeganie ustalonych systemów oceny);

- Materiały dydaktyczne (dostępność i użyteczność materiałów dydaktycznych);

- Merytoryczne przygotowanie prowadzącego (ocena merytorycznego przygotowania prowadzącego do zajęć);

- Możliwość dyskusji (możliwość dyskusji w trakcie zajęć i uzyskania odpowiedzi na zadawane pytania);

- Niezrealizowane zajęcia (liczba/procent odwołanych zajęć, nieodpracowanych w innym terminie);

- Ogólna ocena zajęć (ogólna ocena poziomu prowadzenia zajęć);

- Organizacja zajęć (prawidłowość przebiegu zajęć pod względem organizacyjnym);

- Oryginalność treści zajęć (nowość zagadnień, unikanie powtórzeń treści);

- Powiązanie zajęć z praktyką (odniesienia do przykładów z praktyki);

- Poziom wymagań (poziom wymagań stawianych studentom na zajęciach);

- Punktualność prowadzącego (punktualność rozpoczęcia i zakończenia zajęć);

- Stosunek do studenta (stosunek prowadzącego do studentów);

- Tempo prowadzenia zajęć (utrzymanie właściwego tempa zajęć);

- Wykorzystanie wyposażenia sali (stopień wykorzystania wyposażenia sali do prowadzenia zajęć);

- Zaangażowanie prowadzącego (zaangażowanie prowadzącego w wyjaśnianie omawianych zagadnień i pomysłowość w przekazywaniu wiedzy);

- Zgodność z sylabusem (realizacja zajęć zgodnie z sylabusem).

Mapa nadreprezentacji dla badanej populacji uczelni została przedstawiona na rysunku 1. Cechy różnicujące występują w kolumnach najbardziej skrajnych (najbardziej na lewo i na prawo), z kolei cechy nieróżnicujące umieszczane są w środku mapy. W wyniku przeprowadzonej analizy skupień wyodrębnione zostały trzy grupy uczelni i trzy grupy cech.

Analizując mapę z rysunku 1, można zaobserwować, że lewy górny róg mapy, wskazujący obszar o silnej nadreprezentacji, obejmuje uczelnie SGGW i PJATK. Uczelnie te przy ocenianiu dydaktyków zwracają większą uwagę niż UW, UP, UB na cechy takie, jak: Organizacja zajęć, Możliwość dyskusji, Materiały dydaktyczne, Powiązanie zajęć z praktyką, Oryginalność treści zajęć, Zgodność z sylabusem, Tempo prowadzenia zajęć. Z kolei uczelnie uniwersyteckie: UW, UP, UB wyraźniej koncentrują się na: Zaangażowaniu prowadzącego, Niezrealizowanych zajęciach, Merytorycznym przygotowaniu prowadzącego, Poziomie wymagań i Frekwencji studenta.

Środkowe kolumny mapy odpowiadają cechom nieróżnicującym, występującym w ankietach wszystkich uczelni, takim jak: Ogólna ocena zajęć, Komunikatywność prowadzącego, Stosunek do studenta, czy też Inspirowanie studentów, Punktualność prowadzącego.

Analizując proces nabywania informacji o jakości nauczania za pomocą kwestionariuszy, można sformułować tezę, że nie są one zbyt wiarygodnym źródłem informacji. Studenci wykazują znaczący brak zaufania do ankiet elektronicznych, obawiając się ewentualnych konsekwencji wynikających z wystawienia nauczycielowi niskiej oceny i dlatego albo w ogóle nie wypełniają ankiety, albo też starają się wystawiać wyłącznie oceny pozytywne5. Zdaniem autorów na wiarygodność ocen mają wpływ także inne czynniki: fakt, że niewielki procent respondentów wypełnia ankiety elektroniczne (brak reprezentatywności) oraz że studenci nie są przygotowani w wystarczającym stopniu do przedstawienia merytorycznych, konstruktywnych opinii. Wystawiane oceny oparte są często na emocjach i zależą od bardzo wielu subiektywnych czynników, takich jak np. zdolności studenta, jego umiejętności koncentracji, motywacji do nauki czy osobistych sympatii lub uprzedzeń w stosunku do nauczyciela.

W literaturze zagadnienia pojawiają się propozycje oceniania jakości nauczania na podstawie rezultatów kształcenia - m.in. poprzez analizę rozkładów ocen uzyskanych na egzaminie oraz badanie zależności pomiędzy ocenami średnimi ze studiów a ocenami z zaliczeń i egzaminów dla tego samego przedmiotu 6. Niestety metody te pozostają w sferze badań naukowych, a na uczelniach wciąż podstawą oceny jakości nauczania są ankiety studenckie.

Organizacja przedmiotu poddanego analizie

Na potrzeby określenia kontekstu, poniżej została omówiona organizacja przedmiotu, dla którego zaproponowano badanie jakości pracy nauczyciela.

Realizacja przedmiotu odbywa się w formie wykładów i ćwiczeń. Ćwiczenia prowadzone są w grupach kilkunastoosobowych, zgodnie z planem określającym poruszane tematy i pojęcia wprowadzane w kolejności ustalonej w podstawowej ścieżce dydaktycznej, zdefiniowanej przez osobę odpowiedzialną za przedmiot. Nauczanie w grupach ćwiczeniowych odbywa się w oparciu o posiadane (dostępne dla wszystkich asystentów) wspólne zasoby (materiały) dydaktyczne, o znanej użyteczności dla określonej grupy tematycznej oraz etapu nauczania (z punktu widzenia modelu efektywnego nauczania7). Do zasobów dydaktycznych należą m.in. zadania typu projektowo/problemowego, pytania/polecenia proste, omówienia przykładowych rozwiązań oraz często popełnianych błędów. Asystenci prowadzący grupy ćwiczeniowe zobowiązani są do realizacji zajęć zgodnie z ustaloną ścieżką dydaktyczną, ale posiadają pewną autonomię w kwestii doboru wykorzystywanych na zajęciach materiałów, podziału czasu w ramach grupy tematycznej, a także rozłożenia akcentów pomiędzy poszczególne tematy i pojęcia.

Weryfikacja poznanej w trakcie semestru wiedzy i umiejętności nabytych przez studentów jest przeprowadzana podczas zajęć (ustalonych w planie) przy pomocy trzech sprawdzianów i w formie pisemnej. W czasie sprawdzianu studenci otrzymują tekst wymagań użytkownika na system informatyczny i mają do wykonania jedno zadanie typu projektowo-problemowego oraz kilka lub kilkanaście pytań/poleceń prostych, nazywanych pytaniami dodatkowymi, powiązanych z danym zadaniem projektowym. Taki podział sprawdzianu można odnieść do podstawowych kategorii związanych z nauczaniem: wiedzy, umiejętności i kompetencji. Zgodnie ze Słownikiem pojęć polityki na rzecz uczenia się przez całe życie8, opracowanym przez Międzyresortowy Zespół do spraw uczenia się przez całe życie, w tym Krajowych Ram Kwalifikacji9 (organ pomocniczy Prezesa Rady Ministrów):

- wiedza - to zasób powiązanych ze sobą faktów, zasad, teorii i doświadczeń przyswojonych przez osobę uczącą się,

- umiejętności - to zdolność wykorzystania wiedzy oraz wyćwiczonych sprawności do wykonywania zadań oraz rozwiązywania problemów,

- kompetencje - to wszystko to, co dana osoba wie, rozumie i potrafi wykonać, czyli jej skumulowane efekty uczenia się.

Sprawdzanie wiedzy nabytej przez studentów odbywa się poprzez ocenianie odpowiedzi na pytania dodatkowe, jakie zostały przez nich udzielone na sprawdzianach, a weryfikacja uzyskanych umiejętności jest dokonywana na podstawie oceny skonstruowanego przez nich modelu w zadaniu typu projektowo-problemowego dla określonego tekstu wymagań na system.

Liczba sprawdzianów, ich termin oraz zakres każdego z nich (tematy, pojęcia, rodzaj zadania projektowo-problemowego oraz podstawowy zestaw pytań/poleceń prostych) są określane przez osobę odpowiedzialną za przedmiot. Asystenci samodzielnie wybierają teksty wymagań użytkownika dla każdego sprawdzianu i dla każdej grupy. Mają także możliwość, w ograniczonym zakresie, modyfikacji zestawu pytań dodatkowych. Podczas oceny zadania projektowo-problemowego asystenci powinni wykorzystywać metrykę dedykowaną dla określonego rodzaju zadania. Przy ocenie pytań/poleceń prostych kierują się regułami ich oceny, które w trudniejszych przypadkach mają także postać metryki.

Studenci, którzy otrzymali zaliczenie, przystępują do egzaminu w I i/lub II terminie (tzw. egzaminie poprawkowym). Egzamin ma formę pisemną i, podobnie jak wszystkie sprawdziany, składa się z dwóch części. Pierwsza z nich to zadanie typu projektowo-problemowego, polegające na skonstruowaniu modelu opisującego strukturę wybranego fragmentu dziedziny problemowej, w oparciu o zadany tekst wymagań na system o wielkości 10--15 klas, a druga obejmuje kilkanaście pytań/poleceń prostych, które odnoszą się do modelu zrealizowanego w części pierwszej. Łączny czas przeznaczony na wykonanie obu części wynosi 90 minut.

Teksty wymagań użytkownika są inne dla każdego terminu egzaminu. Nie mogą to być teksty, które zostały wcześniej wykorzystane na zajęciach lub egzaminach w latach poprzednich. W tym celu osoba odpowiedzialna za przedmiot i asystenci opracowują zupełnie nowe wymagania użytkownika na system (każda z osób oddzielnie). Odbywa się to zgodnie z ustalonymi (w postaci pisemnej) założeniami co do zawartości oraz rozmiaru wymagań, określającymi tematy i pojęcia, jakie powinny lub mogłyby zostać poruszone podczas realizacji zadań w części pierwszej i/lub drugiej. Przed akceptacją tekstu wymagań i przydzieleniem go do określonego terminu egzaminu, przeprowadza się weryfikację tekstu w postaci recenzji, którą realizuje inna niż autor osoba spośród zaangażowanych w realizację przedmiotu. Jeśli pierwsza weryfikacja nie jest pozytywna, wymagania poprawiane są przez autora z uwzględnieniem sugestii recenzenta, po czym realizowana jest weryfikacja powtórna i ewentualnie kolejna, aż do czasu uzyskania pozytywnej recenzji. Wydając ocenę pozytywną, recenzent określa stopień trudności wymagań użytkownika w ustalonej skali. Do określonego terminu egzaminu przydzielane są wymagania o takim samym lub zbliżonym stopniu trudności, tym samym tworzy się trzon różnych zestawów egzaminacyjnych.

Po przeprowadzeniu egzaminu w danym terminie prace studentów grupowane są według zestawów egzaminacyjnych, a następnie przydzielane do oceny osobom zaangażowanym w realizację przedmiotu zgodnie z zasadą, że studenci nie powinni być oceniani przez osoby, które prowadziły zajęcia ćwiczeniowe w ich grupach. Zadania projektowo-problemowe są sprawdzane zgodnie z określoną metryką, natomiast zadania proste - zgodnie z ich metrykami lub ustalonymi regułami oceny.

Organizacja badanego przedmiotu została wypracowana w celu ujednolicenia zajęć ćwiczeniowych w grupach prowadzonych przez różne osoby, przy jednoczesnym zachowaniu pewnej autonomii asystentów, niezbędnej np. dla dostosowania procesu nauczania do potrzeb określonej grupy. Natomiast metodologię przygotowywania, przeprowadzania oraz oceny egzaminów stworzono w celu uniezależnienia sposobu oceniania prac egzaminacyjnych od osób sprawdzających, a zatem uniezależnienia procesu oceny końcowej od procesu nauczania.

System pracy osób zaangażowanych w realizację przedmiotu był wielokrotnie ulepszany i modyfikowany. Stale powiększano wspólną bazę zasobów (m.in. wymagań do zadań projektowo-problemowych, pytań i przykładowych rozwiązań), jak również poprawiano organizację przedmiotu (ścieżki dydaktyczne, plan zajęć, organizację ćwiczeń i egzaminu). Aktywności te realizowano nieprzerwanie od co najmniej kilkunastu lat, przy zmieniającym się składzie asystentów, a także osób odpowiedzialnych za przedmiot. Warto także zaznaczyć, że jedną z przyjętych i stosowanych zasad jest prowadzenie co najmniej jednej grupy ćwiczeniowej przez osobę odpowiedzialną za przedmiot w każdej jego edycji. Procesy związane z realizacją przedmiotu osiągnęły, zdaniem autorów, stosunkowo wysoki poziom dojrzałości z punktu widzenia modelu CMM (Capability Maturity Model10), ponieważ zostały one zdefiniowane, uporządkowane, określono mechanizmy pomiaru jakości nauczania oraz zmian (poprawy) wykorzystujące uzyskane wyniki pomiarów. Wszystko to, zgodnie z regułami inżynierii oprogramowania, w znaczącym stopniu powinno pozwolić na uniezależnienie jakości procesu nauczania od "jakości" dydaktyków zaangażowanych w ten proces.

W artykule przedstawiono analizę wyników nauczania studentów Wydziału Informatyki, studiujących w trybie dziennym i uczęszczających na zajęcia z omawianego przedmiotu na II roku studiów. Zebrane dane obejmowały kurs prowadzony w semestrze letnim w roku akademickim 2012/2013. Uczestnicy kursu zostali podzieleni na 6 grup zajęciowych, opisanych cyframi rzymskimi od I do VI. Studentom nadano kolejne numery identyfikacyjne, zaczynając od 1. Asystenci prowadzący zajęcia zostali oznaczeni literami alfabetu łacińskiego (A, B i C).

Cel badań

Za cel badań uznano próbę określenia i weryfikacji sposobów oceniania jakości nauczania w oparciu o:

- porównanie wyników osiąganych przez grupy studenckie prowadzone przez różnych nauczycieli;

- analizę porównawczą wyników osiąganych przez studentów z analizowanego przedmiotu w zestawieniu z wynikami z innych przedmiotów.

W dalszej części artykułu zarysowano propozycję podejścia umożliwiającego dokonanie oceny jakości realizacji procesu nauczania przez nauczyciela, przy założeniu, że powinno ono być niezależne od docelowej dziedziny problemowej.

Propozycja podejścia do oceny jakości realizacji procesu nauczania przez nauczyciela

Zaproponowano podejście oparte na 6 krokach, opisanych następująco:

- stworzenie wstępnej charakterystyki badanego rocznika studentów, traktowanego jako zbiór grup uczestniczących w kursie z danego przedmiotu,

- stworzenie wstępnej charakterystyki grup (ze względu na średnią ze studiów),

- analiza wyników grup osiągniętych po II terminie egzaminu (obejmujących również wyniki z egzaminu w I terminie),

- analiza różnic pomiędzy średnimi ocenami z egzaminu po II terminie dla grup (traktowanych jako całość) a średnimi ze studiów,

- stworzenie mapy nadreprezentacji,

- podsumowanie wyników nauczania dla całego roku.

Charakterystyka populacji studentów traktowanej jako zbiór grup uczestniczących w kursie z danego badanego przedmiotu

W tej części powinien znaleźć się opis zbioru grup uczestniczących w realizacji danego przedmiotu. Należy podać informacje dotyczące przedmiotu poddawanego analizie, określić rodzaj studiów (np. informatyka, studia stacjonarne), semestr i rok studiów (przykładowo: semestr letni w roku akademickim 2012/2013 lub też w skrócie: semestr letni 2013), liczbę studentów na roku, liczbę grup oraz liczbę osób uczących (asystentów).

Wstępna charakterystyka grup (ze względu na średnią ze studiów)

Sformułowanie "wstępna charakterystyka grup" oznacza stan początkowy, czyli stan przed rozpoczęciem realizowania procesu nauczania. Dla każdej z grup studenckich na roku należy określić wartość oczekiwaną E(X) średniej ze studiów studentów należących do danej grupy, liczoną na podstawie ocen do momentu (semestru) poprzedzającego rozpoczęcie realizowania kursu (dla analizowanych danych dyskretnych wartość oczekiwana zmiennej losowej jest równa średniej arytmetycznej11), odchylenie standardowe σ(X) i współczynnik zmienności CV(X)12. Do grup, oznaczonych numerami, przypisane są osoby nauczające, oznaczone umownymi symbolami. Wstępną charakterystykę grup z początkowym uporządkowaniem (według kolejnych numerów) należy przedstawić w postaci tabeli (patrz tab. 1). Dodatkowo, na jej końcu zostały dołączone dwa wiersze z uśrednionymi wynikami dla wszystkich grup: I-VI (G) oraz średnim wynikiem dla wszystkich studentów roku: I-VI (S). Wartości w tych wierszach nie są identyczne ze względu na różne rozmiary grup. Symbolem x oznaczono uśredniony wynik dla grup: I-VI (G), a symbolem ▲ - średni wynik dla wszystkich studentów na roku: I-VI (S).

| Grupa / średnia | Liczba osób | Średnia ze studiów - wartość oczekiwana E(X) | Odchylenie standardowe σ(X) | Współczynnik zmienności CV(X) | Nauczyciel / symbol |

| ... | ... | ... | ... | ... | |

| I-VI(G) | x | ||||

| I-VI(S) | ▲ | ||||

Źródło: opracowanie własne.

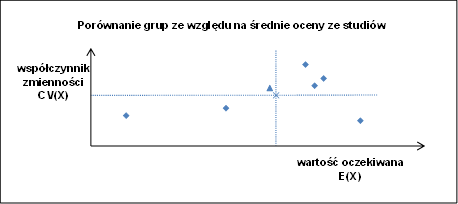

W kolejnym kroku, na podstawie danych zawartych w tabeli 1, należy sporządzić wykres umożliwiający porównanie grup ze względu na średnie oceny ze studiów, umieszczając na osi OX wartości oczekiwane, a na osi OY - współczynniki zmienności (patrz rys. 2). Wynik każdej z grup został oznaczony symbolem ♦, natomiast średnie dla grup, zgodnie z tabelą 1, symbolami x oraz ▲. Dwie przecinające się wykropkowane linie wyznaczają uśredniony wynik dla grup I-VI (G) i mają na celu ułatwienie porównania rezultatów osiągniętych przez poszczególne grupy.

Trzeci element charakterystyki grup (oprócz tabeli 1 i rysunku 2) stanowi tabela z uszeregowaniem grup od najlepszej do najgorszej ze względu na średnią ze studiów (tab. 2).

| Układ grup ze względu na średnią ocenę ze studiów numer grupy: średnia ze studiów |

Źródło: opracowanie własne.

W końcowej części charakterystyki grup powinna zostać zamieszczona analiza informacji zawartych w tabeli 1 i 2 oraz na wykresie (rysunku 2).

Analiza wyników grup osiągniętych po II terminie egzaminu

W opisywanym badaniu dane pierwotne dla kursu w semestrze letnim roku 2013 udostępnione przez dziekanat obejmowały: oceny zaliczeniowe, oceny uzyskane z egzaminu w I i II terminie z danego przedmiotu oraz średnie oceny ze studiów dla poszczególnych studentów. Po przeprowadzeniu wstępnej analizy wyżej wymienionych danych uznano, że na podstawie ocen zaliczeniowych trudno wyciągnąć miarodajne wnioski. Warto zauważyć, że na ocenę z zaliczenia składały się wyniki z trzech sprawdzianów, weryfikujących wiedzę i umiejętności studentów w trakcie całego semestru, gdy tymczasem oceny z egzaminów były wystawiane pod koniec semestru, co stanowiło pewien obraz efektów końcowych kształcenia. Dodatkowo, zdaniem autorów, oceny z zaliczenia mogły być bardziej subiektywne niż oceny z egzaminu, które były wystawiane przez inne osoby niż prowadzący ćwiczenia dla każdego studenta. Zarówno z tego powodu, jak i w celu uproszczenia podejścia zdecydowano, że oceny zaliczeniowe zostaną pominięte w dalszych rozważaniach na obecnym etapie badań. Proponuje się także aby oceny poszczególnych studentów z I i II terminu egzaminu zastąpić ich odpowiednimi średnimi arytmetycznymi uwzględniającymi oba terminy. Dla osób, które zdały egzamin w pierwszym terminie jako wartość średniej wpisywana jest ocena z pierwszego terminu (przyjmując umownie, że ocena w drugim terminie wynosi 0). Natomiast dla tych studentów, którzy zdawali dwukrotnie, jako wartość oceny uzyskanej w pierwszym terminie wlicza się 2.

Dla ścisłości warto zaznaczyć, że analizie poddawane powinny być wyłącznie wyniki osiągnięte przez tych studentów, którzy uzyskali zaliczenie z przedmiotu i przystąpili do egzaminu w I lub w I i II terminie. Krok ten należy przeprowadzić z wykorzystaniem tabel i wykresu w kolejności takiej, jak we wstępnej charakterystyce grup (jak w tabeli 1, rysunku 2, tabeli 2), przy czym zamiast średniej oceny ze studiów należy uwzględnić średnią ocenę z egzaminu po II terminie. Średnia ocena z egzaminu po II terminie oznacza ocenę z egzaminu w pierwszym terminie (jeżeli student przystąpił wyłącznie do tego egzaminu) lub też średnią ocenę z dwóch egzaminów (jeżeli przystąpił do egzaminu w obu terminach). Opis wyników grup po II terminie egzaminu powinna kończyć analiza podsumowująca informacje zawarte w tabelach i na wykresie.

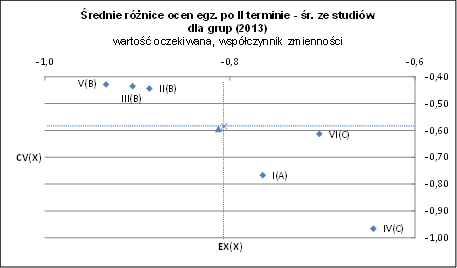

Analiza różnic pomiędzy średnimi ocenami z egzaminu po II terminie dla grup traktowanych jako całość a średnimi ze studiów

Różnica między średnią oceną z egzaminu po II terminie a średnią ze studiów pozwala określić wpływ danego przedmiotu (a dokładniej: oceny uzyskanej z egzaminu z danego przedmiotu) na średnią ze studiów, zarówno dla każdego studenta, jak i dla grupy, której jest on członkiem.

W tym celu należy przeanalizować dane dotyczące wyników grup z wykorzystaniem tabel i wykresu w kolejności takiej, jak we wstępnej charakterystyce grup (jak w tabeli 1, na rysunku 2, w tabeli 2), przy czym zamiast średniej oceny ze studiów należy uwzględnić różnicę między średnią oceną z egzaminu po II terminie a średnią ze studiów. Opis wyników powinna kończyć analiza podsumowująca informacje zawarte w tabelach i na wykresie.

Mapa nadreprezentacji

W kolejnym kroku autorzy proponują wykonanie gradacyjnej analizy danych13 z wykorzystaniem programu GradeStat14 (patrz dodatek - mapa nadreprezentacji). Narzędzie to umożliwia identyfikację trendów w populacji oraz czytelne zobrazowanie rezultatów analizy w postaci graficznej.

W celu sporządzenia mapy nadreprezentacji należy określić badaną populację oraz zbiór opisujących ją cech. Zbiór ten może być inny dla analizowanych różnych przedmiotów, gdyż jest uzależniony od specyficznych właściwości danego przedmiotu nauczania.

W końcowym etapie przeprowadzonej oceny należy dołączyć mapę nadreprezentacji oraz przedstawić analizę podsumowującą wynik gradacyjnej analizy danych.

Podsumowanie wyników nauczania dla całego roku

Podsumowanie wyników danego roku powinno odnosić się do oceny jakości realizacji procesu nauczania danego przedmiotu, dokonanej na podstawie wcześniejszych analiz.

Przykład zastosowania proponowanej metody oceny jakości pracy nauczyciela - semestr letni roku akademickiego 2012/2013

Charakterystyka populacji studentów traktowanej jako zbiór grup uczestniczących w kursie z badanego przedmiotu

W semestrze letnim 2013 r. w zajęciach z przedmiotu związanego z projektowaniem systemów informacyjnych na kierunku informatyka studiów stacjonarnych uczestniczyło 82 studentów, podzielonych na 6 grup, które były prowadzone przez 3 asystentów. Studentom nadano kolejne numery identyfikacyjne - od 1 do 82. Asystenci zostali oznaczeni literami A, B i C.

Wstępna charakterystyka grup (ze względu na średnią ze studiów)

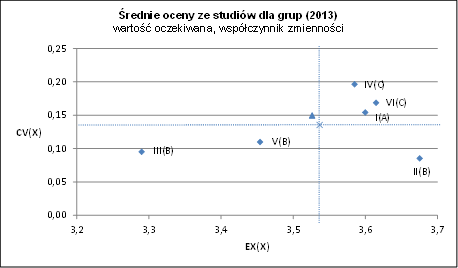

Wstępna charakterystyka grup została zamieszczona w tabeli 3.

| Grupa / średnia | Liczba osób | Średnia ze studiów- wartość oczekiwana E(X) | Odchylenie standardowe σ(X) | Współczynnik zmienności CV(X) | Nauczyciel / symbol |

| I | 13 | 3,60 | 0,55 | 0,15 | A |

| II | 13 | 3,68 | 0,31 | 0,09 | B |

| III | 16 | 3,29 | 0,31 | 0,10 | B |

| IV | 14 | 3,59 | 0,70 | 0,20 | C |

| V | 14 | 3,45 | 0,38 | 0,11 | B |

| VI | 14 | 3,62 | 0,61 | 0,17 | C |

| I-VI(G) | 3,54 | 0,48 | 0,14 | x | |

| I-VI(S) | 3,53 | 0,53 | 0,15 | ▲ | |

Źródło: opracowanie własne.

Porównanie grup ze względu na średnią ocenę ze studiów zostało przedstawione na rysunku 3.

Źródło: opracowanie własne.

Uporządkowanie grup od najlepszej do najgorszej ze względu na średnią ze studiów zawarto w tabeli 4.

| Układ grup ze względu na średnią ocenę ze studiów |

| II: 3,68 |

| VI: 3,62 |

| I: 3,60 |

| IV: 3,59 |

| V: 3,45 |

| III: 3,29 |

Źródło: opracowanie własne.

Jak wynika z tabeli 4 i rysunku 3, najlepszą z grup początkowo była grupa II, która osiągnęła najwyższą średnią ze studiów dla grupy traktowanej jako całość (3,68) i której skład był najbardziej wyrównany (najniższy współczynnik zmienności równy 0,09). Kolejne trzy grupy o zbliżonej średniej ze studiów to grupy VI (3,62), I (3,60) i IV (3,59), dla których widoczne jest większe zróżnicowanie. Ostatnie dwie grupy V (3,45) i III (3,29), o najniższych ocenach średnich dla grupy jako całości, składały się z osób o mniej więcej wyrównanym poziomie.

Warto zauważyć, że asystent B opiekował się grupami o najbardziej wyrównanym składzie (najniższe współczynniki zmienności) w przeciwieństwie do asystenta C (najwyższe współczynniki zmienności).

Analiza wyników grup osiągniętych po II terminie egzaminu

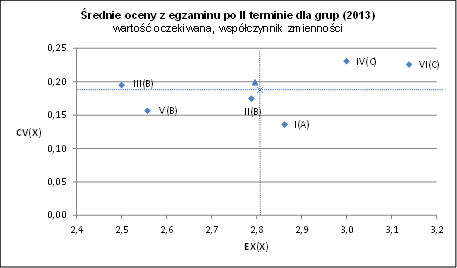

Tabela 5 zawiera średnie oceny z egzaminu po II terminie dla grup.

| Grupa / średnia | Średnia z egzaminu po II terminie - wartość oczekiwana E(X) | Odchylenie standardowe σ(X) | Współczynnik zmienności CV(X) | Nauczyciel / symbol |

| I | 2,86 | 0,39 | 0,14 | A |

| II | 2,79 | 0,49 | 0,17 | B |

| III | 2,50 | 0,49 | 0,19 | B |

| IV | 3,00 | 0,69 | 0,23 | C |

| V | 2,56 | 0,40 | 0,16 | B |

| VI | 3,14 | 0,71 | 0,23 | C |

| I-VI(G) | 2,81 | 0,53 | 0,19 | x |

| I-VI(S) | 2,80 | 0,56 | 0,20 | ▲ |

Źródło: opracowanie własne.

Porównanie grup ze względu na średnią ocenę z egzaminu po II terminie zostało przedstawione na rysunku 4.

Źródło: opracowanie własne.

Uporządkowanie grup od najlepszej do najgorszej ze względu na średnią ocenę z egzaminu po II terminie zawarto w tabeli 6.

| Układ grup ze względu na średnią ocenę z egzaminu |

| VI: 3,14 |

| IV: 3,00 |

| I: 2,86 |

| II: 2,79 |

| V: 2,56 |

| III: 2,50 |

Źródło: opracowanie własne.

Analizując tabelę 6 i rysunek 3, można zauważyć, że średnie wyniki egzaminu dla studentów z grupy III i V były znacząco gorsze, a z grup VI i IV - znacząco lepsze aniżeli średnie wyniki studentów z pozostałych grup.

Porównanie układów grup ze względu na średnią ze studiów i średnią z egzaminu po II terminie (tabele 4 i 6) prowadzi do wniosku, że najlepsze wyniki nauczania (na podstawie średnich ocen z egzaminu) zostały osiągnięte w grupach VI i IV, które były prowadzone przez asystenta C. W tych grupach można także dostrzec najwyższe wartości współczynnika zmienności, świadczące o relatywnie większym zróżnicowaniu ocen z egzaminu niż w pozostałych grupach, czego prawdopodobną przyczyną jest największe zróżnicowanie składu obu tych grup "na starcie". Grupa II, prowadzona przez asystenta B, składała się z potencjalnie najlepszych studentów (z najwyższą średnią ze studiów), ale po egzaminie uplasowała się na czwartym miejscu. Pozostałe grupy: I, V i III nie zmieniły swoich pozycji po egzaminie.

Analiza różnic pomiędzy średnimi ocenami z egzaminu po II terminie dla grup traktowanych jako całość a średnimi ze studiów dla tych grupTabela 7 zawiera różnice między średnią oceną z egzaminu po II terminie a średnią ze studiów, wyliczone dla grup.

| Grupa / średnia | Różnica: średnia z egz. po II terminie - średnia ze studiów wartość oczekiwana E(X) | Odchylenie standardowe σ(X) | Współczynnik zmienności CV(X) | Nauczyciel / symbol |

| I | -0,76 | 0,59 | -0,77 | A |

| II | -0,89 | 0,39 | -0,44 | B |

| III | -0,91 | 0,39 | -0,44 | B |

| IV | -0,65 | 0,62 | -0,97 | C |

| V | -0,93 | 0,40 | -0,43 | B |

| VI | -0,70 | 0,43 | -0,61 | C |

| I-VI(G) | -0,81 | 0,47 | -0,59 | x |

| I-VI(S) | -0,81 | 0,48 | -0,59 | ▲ |

Źródło: opracowanie własne.

Porównanie grup ze względu na średnią różnicę między średnią oceną z egzaminu po II terminie a średnią ze studiów zostało przedstawione na rysunku 5.

Źródło: opracowanie własne.

Uporządkowanie grup od najlepszej do najgorszej ze względu na średnią różnicę między średnią oceną z egzaminu po II terminie a średnią oceną ze studiów zawarto w tabeli 8.

| Układ grup ze względu na różnicę: średnia z egz. po II terminie - średnia ze studiów |

| IV: -0,65 |

| VI: -0,70 |

| I: - 0,76 |

| II: -0,89 |

| III: -0,91 |

| V: -0,93 |

Źródło: opracowanie własne.

Można zauważyć (patrz tab. 7), że we wszystkich grupach średnie oceny z egzaminu były niższe aniżeli średnie ze studiów (różnice mają ujemne wartości). Relatywnie najmniejsza (ujemna) różnica między oceną z egzaminu a średnią ze studiów obserwowalna jest w grupach IV, VI i I, a największa - w grupach V, III i II. Uzyskany układ grup ze względu na różnicę średniej z egzaminu po II terminie i średniej ze studiów (tab. 8) jest w zasadzie taki sam jak układ grup ze względu na średnią ocenę z egzaminu po II terminie (tab. 6), z tym że grupy III i V wymieniły się swoimi pozycjami. Stanowi to potwierdzenie wcześniejszych wniosków.

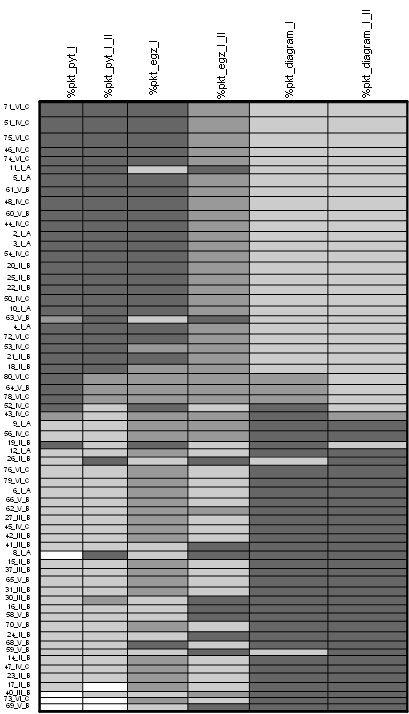

Mapa nadreprezentacji

Analizie poddano populację składającą się z 65 studentów, którzy przystąpili do egzaminu z przedmiotu poświęconego nauczaniu projektowania systemów informacyjnych w I terminie lub w I i II terminie (pozostali studenci z roku nie zostali dopuszczeni do egzaminu z powodu niezaliczenia ćwiczeń). Każdemu studentowi została przypisana unikatowa etykieta: nr studenta_nr grupy_etykieta asystenta.

Zbiór cech opisujących analizowaną populację studentów dla badanego przedmiotu przedstawiono w tabeli 9. Wybrane cechy odzwierciedlają specyficzną strukturę egzaminu dla tego przedmiotu, złożonego z dwóch części: zadania projektowo-problemowego oraz pytań dodatkowych. Warto zauważyć, że tabela 9 nie zawiera cechy opisującej średnią ze studiów. Analiza porównawcza dwóch map nadreprezentacji: mapy dla zbioru cech określonych w tabeli 9 oraz mapy dla tego samego zbioru cech z dodatkową cechą "średnia ze studiów" nie wykazała istotnych różnic. Niewielkie przesunięcia w uszeregowaniu wierszy pomiędzy mapami praktycznie nie miały wpływu na uzyskiwane (takie same) wnioski. W związku z powyższym, w celu uproszczenia (zminimalizowania) zbioru cech, podjęto decyzję o pominięciu tej cechy.

| Cecha | Przedział wartości | Etykieta kolumny na mapie nadreprezentacji |

| Proc. punktów zdobytych w I terminie egzaminu - za część pierwszą i drugą traktowane łącznie | [0;100] | %pkt_egz_I |

| Proc. punktów zdobytych w I terminie egzaminu - za część pierwszą | [0;100] | %pkt_diagram_I |

| Proc. punktów zdobytych w I terminie egzaminu - za część drugą | [0;100] | %pkt_pyt_I |

| średni proc. punktów zdobytych po II terminie egzaminu | [0;100] | %pkt_egz_I_II |

| średni proc. punktów zdobytych po II terminie egzaminu - za część pierwszą | [0;100] | %pkt_diagram_I_II |

| średni proc. punktów zdobytych po II terminie egzaminu - za część drugą | [0;100] | %pkt_pyt_I_II |

Źródło: opracowanie własne.

Mapę nadreprezentacji uwzględniającą wszystkie cechy zawarte w tabeli 9 zaprezentowano na rysunku 6.

Źródło: opracowanie własne.

Górne wiersze mapy odpowiadają w większości studentom asystenta C, którzy uzyskali zdecydowanie wyższe łączne oceny (czego dowodem są wiersze o większej wysokości) niż reszta populacji. Przykładowo studenci o numerach 71, 51, 75 uzyskali odpowiednio 82,5 proc., 85,7 proc., 76,4 proc. punktów z egzaminu (są to średnie po dwóch terminach egzaminu). W tej części mapy sporadycznie umieszczone zostały również wiersze skojarzone z osobami nauczanymi przez asystentów A (z grupy I) i B (z grup II i V).

Dolne wiersze mapy nadreprezentacji odpowiadają studentom, którzy uzyskali z egzaminu zdecydowanie mniej punktów niż pozostała część badanej populacji. Mieli oni niewielki procentowy wkład w łączną punktację uzyskaną przez wszystkich studentów (odpowiadające im wiersze mapy mają zdecydowanie mniejsze wysokości). W tej grupie wyraźnie przeważali studenci asystenta B (głównie z grupy III).

Zarówno w środkowej, jak i w dolnej części mapy można zauważyć występowanie wysokich wierszy, co świadczy o tym, że skojarzone z tymi wierszami osoby uzyskały stosunkowo wysoką średnią notę z egzaminu, dzięki dobrej ocenie modelu opisującego strukturę wybranego fragmentu dziedziny problemowej, a zdecydowanie słabszej ocenie odpowiedzi na pytania dodatkowe lub odwrotnie. Można tu wymienić np. studenta o numerze 76, uczęszczającego do grupy VI prowadzonej przez asystenta C, który uzyskał 90 proc. punktów za skonstruowany model struktury i tylko 45 proc. punktów za pytania dodatkowe sprawdzające wiedzę.

Wnioski wynikające z analizy mapy można sformułować następująco:

- studenci asystenta C uzyskali najlepsze wyniki, co zdaniem autorów, świadczy o tym, że w ramach realizowanego przedmiotu w największym stopniu nabyli wiedzę i umiejętności przydatne w przyszłości na rynku pracy;

- grupa asystenta A wypadła gorzej, niż grupy asystenta C, ale studenci tej grupy w większości uplasowali się w górnej i w środkowej części mapy;

- najgorzej na tle wszystkich grup wypadli studenci asystenta B (głównie z grupy III);

- wyniki gradacyjnej analizy danych, chociaż mniej dokładne, ale z naciskiem na identyfikowanie trendów występujących w danej populacji, potwierdzają wnioski wyciągnięte po przeprowadzeniu podstawowych badań statystycznych.

Podsumowanie wyników nauczania dla całego roku

Uwzględniając wcześniejsze rozważania, można wyciągnąć wniosek, że studenci grup asystenta C (mimo tego, że nie były to grupy z najwyższą średnią ze studiów i o najbardziej wyrównanym składzie) wykazali się największą wiedzą i umiejętnościami, uzyskując zdecydowanie lepsze wyniki niż studenci pozostałych grup (najwyższe średnie z egzaminu - patrz tabela 6 i najmniejsze różnice między średnimi ze studiów a ocenami uzyskanymi z egzaminu - patrz tabela 8). Natomiast studenci asystenta B uzyskali zdecydowanie zbyt niskie wyniki w porównaniu z ich średnimi ze studiów oraz najbardziej wyrównanymi poziomami studentów w grupach. Grupa II asystenta B, która uzyskała najwyższą średnią ze studiów, uplasowała się po egzaminie dopiero na 4 miejscu, co świadczy o tym, że studenci nie zostali wystarczająco dobrze przygotowani do egzaminu przez asystenta prowadzącego ich grupę i w sumie w mniejszym zakresie nabyli wiedzę i umiejętności aniżeli studenci z pozostałych grup.

Podsumowanie

Przedstawione w artykule studium przypadku zawiera analizę oceny jakości nauczania opartą na wykorzystaniu wartości oczekiwanej (średniej arytmetycznej), współczynnika zmienności i analizy gradacyjnej. Została ona zorientowana na końcowe efekty pracy nauczycieli akademickich, natomiast nie dotyczy oceny podejmowanych przez nich poszczególnych działań czy zachowań w celu osiągnięcia dobrych wyników nauczania. Wyniki, jakie uzyskano dla badanego przedmiotu prezentują pierwszy krok badań w tym zakresie i obejmują tylko jeden rocznik studentów. Autorzy rozpoczęli dalsze prace, które dotyczą analizy ocen z kolejnej edycji tego samego przedmiotu i mają na celu potwierdzenie poprawności zarysowanego podejścia do pomiaru jakości pracy nauczyciela z wykorzystaniem oceny wiedzy i umiejętności jego studentów.

Przedstawiony w opracowaniu sposób oceniania efektywności procesu nauczania wymaga posiadania dostępu do bazy danych zawierającej oceny zaliczeniowe i/lub wyniki egzaminów z określonego przedmiotu oraz średnie oceny ze studiów. Dla rozważonego w artykule przedmiotu pominięte zostały oceny zaliczeniowe, ale w pewnych przypadkach mogłyby zostać włączone do analizy. Jest to planowane w dalszych etapach prac nad zaproponowanym podejściem. Autorzy uważają, że w analogiczny sposób można byłoby przeprowadzić analizę wyników nauczania w odniesieniu do innych przedmiotów, pod warunkiem, że zostanie spełnione podstawowe założenie, iż egzamin umożliwia weryfikację efektów kształcenia uzyskanych przez studentów podczas ćwiczeń.

Silnie ustrukturyzowany i dobrze zorganizowany sposób prowadzenia odgrywa pozytywną rolę, jeżeli chodzi o zapewnienie jakości nauczania przedmiotów typowo technicznych (inżynierskich). Dlatego można przypuszczać, że przeprowadzenie opisanej analizy jest możliwe dla tego rodzaju przedmiotów. Trudno jednak przesądzać na tym etapie badań o niemożności zastosowania tej propozycji na przykład dla przedmiotów humanistycznych.

Autorzy zaprezentowanych w artykule badań statystycznych wyrażają przekonanie, że stanowią one próbę bardziej obiektywnego podejścia do kwestii oceny efektywności procesu nauczania niż ma to miejsce w przypadku kwestionariuszy wypełnianych przez studentów. Zdaniem autorów ankiety studenckie nie udzielają wiarygodnej odpowiedzi na pytania związane z jakością pracy nauczyciela: czy i w jakim stopniu prowadzeni przez niego studenci nabyli odpowiednią wiedzę, umiejętności i kompetencje? Zdarza się, że stanowią swoisty ranking popularności dydaktyka. Subiektywne oceny studentów mogą być również krzywdzące - taki przypadek miał miejsce na uczelni, w której zrealizowano opisane badanie. Studenci ocenili nisko nauczyciela, którego skuteczność nauczania była stosunkowo wysoka.

Weryfikacja poprawności i użyteczności zaprezentowanego podejścia wymaga przeprowadzenia analizy ocen z wybranego przedmiotu dla kolejnych roczników. Można byłoby także rozszerzyć badania na inne przedmioty. Przy założeniu, że kolejne próby potwierdziłyby poprawność zaproponowanej metody, analiza ocen realizowana w ten sposób mogłaby stanowić znaczącą pomoc nie tylko dla osób nadzorujących pracę nauczycieli, lecz także dla nich samych w celu doskonalenia swoich umiejętności. Uzyskiwane wyniki są stosunkowo proste w interpretacji, a zarysowana metoda byłaby łatwa do implementacji w systemach elektronicznej obsługi dziekanatu i mogłaby zostać jednym z elementów polityki jakości kształcenia.

Dodatek - mapa nadreprezentacji

Jednym ze sposobów prezentacji wyników w programie GradeStat jest mapa nadreprezentacji15, przedstawiana za pomocą macierzy, której kolejne wiersze przypisane są elementom badanej populacji, natomiast kolumny odpowiadają opisującym ją cechom.

Wysokość wiersza odzwierciedla wagę całościowej oceny skojarzonego z tym wierszem elementu populacji na tle wszystkich elementów, tzn. określa, jaki jest udział sumy wartości wszystkich cech dla tego elementu w sumie wartości wszystkich cech dla całej populacji. Im bardziej znaczący wkład, tym wiersz jest wyższy. Analogicznie jest dla szerokości kolumn.

Odcień szarości pola mapy wynika ze stosunku wartości rzeczywistej do wartości oczekiwanej dla przewidywanej cechy elementu, przy czym czarne lub ciemno-szare pole oznacza nadreprezentację, a jasno-szare lub białe pole - niedoreprezentację tej cechy.

Mapa nadreprezentacji pozwala na określenie trendu występującego w danej populacji, porządkującego wiersze i kolumny w taki sposób, że elementy populacji (wiersze) umieszczone na początku uporządkowania osiągają wysokie wartości tych cech (kolumny), które również zostały umieszczone na początku uporządkowania (lewy, górny róg mapy).

W celu sporządzenia mapy nadreprezentacji należy określić badaną populację oraz zbiór opisujących ją cech.

Bibliografia

- Allesi S.M., Trollip S.R., Multimedia for learning: Methods and development, Allyn and Bacon, Needham Heights 2001.

- Bąk I., Wawrzyniak K., Ocena jakości nauczania przedmiotów ekonomicznych na przykładzie Wydziału Ekonomicznego Zachodniopomorskiego Uniwersytetu Technologicznego w Szczecinie, http://repozytorium.uni.lodz.pl:8080/xmlui/handle/11089/5572.

- Cieciora M., Zarządzanie jakością procesu dydaktycznego w szkole wyższej, Wydawnictwo PJWSTK, Warszawa 2015.

- Grudowski P., Lewandowski K., Pojęcie jakości kształcenia i uwarunkowania jej kwantyfikacji w uczelniach wyższych, "Zarządzanie i finanse" 2012, R. 10, nr 3, s. 394-403.

- Kowalczyk T., Pleszczyńska E., Ruland F. (eds.), Grade Models and Methods for Data Analysis, With Applications for the Analysis of Data Populations, Springer Verlag, Berlin-Heidelberg-New York 2004.

- Krajowe Ramy Kwalifikacji uczenia się przez całe życie, http://www.nauka.gov.pl/krajowe-ramy-kwalifikacji-szkolnictwo.

- Książyk J., Matyja O., Pleszczyńska E., Wiech M. (red.), Analiza danych medycznych i demograficznych przy użyciu programu GradeStat, Instytut Podstaw Informatyki Polskiej Akademii Nauk, Instytut "Pomnik - Centrum Zdrowia Dziecka", Warszawa 2005.

- Na UwB wprowadzono elektroniczne ankiety, Kurier Poranny, 2012, http://www.poranny.pl/wiadomosci/bialystok/art/5464232,na-uwb-wprowadzono-elektroniczne-ankiety,id,t.html.

- Paulk M.C., et al., Capability Maturity Model for Software, CMU/SEI-91-TR-24, Carnegie Mellon University, Software Engineering Institute, Pittsburgh 1991.

- Perspektywa uczenia się przez całe życie, Załącznik 4: Słownik pojęć polityki na rzecz uczenia się przez całe życie, http://bip.men.gov.pl/wp-content/uploads/sites/2/2011/06/plll_projekt28czerwca.pdf.

- Podgórski J., Statystyka od podstaw, Państwowe Wydawnictwo Ekonomiczne, Warszawa 1992.

- Stemposz E., Jodłowski A., Stasiecka A., Zarys metodyki wspierającej naukę projektowania systemów informacyjnych, Wydawnictwo PJWSTK, Warszawa 2013.

- Stemposz E., Stasiecka A., Jodłowski A., The Analysis of Some Factors Influencing the Quality of Teaching Processes, [w:] Computing in Science and Technology 2013, Monographs in Applied Informatics, Warszawa 2013/2014, s. 87-98.