E-mentor nr 2 (49) / 2013

Spis treści artykułu

- Wprowadzenie

- Egzaminowanie

- Standard Question and Test Interoperability (QTI)

- Metodologie testowania wiedzy

- Sterowanie przebiegiem egzaminu za pomocą wartości parametrów

- Ewaluacja wiedzy z przedmiotu biostatystyka

- Budowa baz egzaminacyjnych

- Opinie studentów po elektronicznym egzaminie

- Podsumowanie

- Bibliografia

- Netografia

Informacje o autorach

Przypisy

1 IMS Question & Test Interoperability Overview, http://www.imsglobal.org/question/qtiv2p1/imsqti_oviewv2p1.html, [18.04.2013].

2 Niniejszy spis wzorców został podany w języku angielskim ze względu na brak stabilnego polskiego przekładu. Polskie określenia podane przez autorów opisują zastosowanie wzorca.

3 A. Ren-Kurc, M. Roszak, Ewaluacja procesu dydaktycznego. Organizacja egzaminów testowych i ankietowania, [w:] J.Migdałek, A.Stolińska (red.), Technologie Informacyjne w Warsztacie Nauczyciela, Nowe wyzwania edukacyjne implikowane rozwojem technologii informacyjnej, Wydawnictwo Naukowe Uniwersytetu Pedagogicznego w Krakowie, Kraków 2011, s. 253-260.

4 Zawartości ekranów pochodzą z wersji portalu e-learningowego OLAT 6.7 zainstalowanej przez autorów dla testowania standardu QTI.

5 API (Application Programming Interface) to biblioteka programistyczna realizująca standard QTI właściwa dla danej technologii i narzędzi, w których powstał LCMS.

Standard Question and Test Interoperability (QTI) - ewaluacja wiedzy studenta

Magdalena Roszak, Barbara Kołodziejczak, Wojciech Kowalewski, Anna Ren-Kurc

Wprowadzenie

Artykuł prezentuje standard elektronicznego egzaminowania QTI wraz z przykładowym egzaminem praktycznym ze statystyki na kierunku lekarskim. Przedstawia także opinie studentów dotyczące pilotażowego wdrożenia elektronicznego egzaminu jako formy zaliczenia przedmiotu „biostatystyka” po tradycyjnym kursie stacjonarnym.

Egzaminowanie

Ewaluacja wiedzy statystycznej studentów prowadzona jest na większości polskich uczelni tradycyjnie, w formie pisemnej na papierze lub ustnej. Obie formy egzaminowania wymagają dużego nakładu pracy od strony merytorycznej (ułożenia kilku różnych zestawów pytań egzaminacyjnych) oraz organizacyjnej (zapewnienia warunków do samodzielnej pracy każdemu studentowi podczas egzaminu pisemnego). Po egzaminie wykładowca musi poświęcić sporo czasu na sprawdzenie prac i przesłanie zdającym informacji o ocenach. W przypadku kilku terminów tego samego egzaminu i egzaminów poprawkowych cała procedura się powtarza. Podobnie jest w kolejnym semestrze i w nowym roku akademickim.

Jednak korzystając z portali e-learningowych, można egzamin tradycyjny zamienić na egzamin elektroniczny w formie testu. Wymaga on na początku większego nakładu pracy w porównaniu z egzaminem tradycyjnym, ale znacznie ułatwia i usprawnia proces ewaluacji wiedzy studentów w kolejnych kilku semestrach.

Właściwą metodykę przeprowadzania egzaminu testowego gwarantuje stosowanie standardu Question and Test Interoperability (QTI), opracowanego przez międzynarodową organizację IMS Global Learning Consortium1 (QTI 1.2 - rok 2002, QTI 2.1 - rok 2010). Pytania egzaminacyjne mogą być dzielone na grupy o różnym stopniu trudności i z różną punktacją. Standard gwarantuje indywidualizację egzaminu przez losowanie pytań dla każdego studenta oraz umożliwia jednolite dla wszystkich kontrolowanie czasu rozwiązywania testu od indywidualnego momentu rozpoczęcia pracy.

Praca niezbędna do przygotowania bazy pytań testowych z danej dziedziny rozkłada się na wielokrotnie prowadzoną ewaluację wiedzy studentów w ciągu kolejnych lat. Zakładamy, że „czas życia” merytorycznej bazy pytań z przedmiotu to 5 lat. Baza zbudowana w standardzie QTI może współpracować z dowolnym portalem e-learnigowym spełniającym standardy edukacji zdalnej w zakresie egzaminowania. Może być stosowana podczas zaliczeń cząstkowych, egzaminów końcowych oraz testów samosprawdzających (tzw. self-testów).

W tabeli 1 zaprezentowano porównanie egzaminu elektronicznego z egzaminem tradycyjnym z uwzględnieniem najistotniejszych, zdaniem autorów, elementów procesu egzaminowania.

| Egzamin tradycyjny | Egzamin elektroniczny |

| Baza pytań na jeden egzamin. | Baza pytań na kilka lat egzaminowania. |

| Zaliczenia i egzaminy poprawkowe wymagają tworzenia nowych zestawów pytań. | Zaliczenia i egzaminy poprawkowe nie wymagają tworzenia nowych pytań. |

| Przygotowanie testów wymaga zachowania procedur tajności (powielanie i dystrybucja). | Brak tego etapu w elektronicznej formie egzaminowania. |

| Budowa kilku zestawów pytań egzaminacyjnych powoduje zwielokrotnienie nakładu pracy. | Zestawy losowane indywidualnie z jednej bazy pytań. |

| Niełatwa w utrzymaniu dyscyplina czasu w trakcie egzaminu. | Automatyczna i indywidualna dla każdego studenta kontrola czasu. |

| Trudności w utrzymaniu dyscypliny podczas egzaminu. | Samodzielna praca studenta indywidualny zestaw pytań dla każdego studenta. |

| Ocena po kilku dniach. | Wynik natychmiast po egzaminie. |

| Wyniki przesyłane pocztą elektroniczną lub wpisywane do wirtualnego dziekanatu. | Wynik natychmiastowy, zapisany w zasobach serwera edukacji zdalnej, widoczny zarówno dla studenta jak i wykładowcy. |

Źródło: opracowanie własne

Standard Question and Test Interoperability (QTI)

Obecnie stosowane są dwa standardy QTI. Standard QTI 1.2 umożliwia tworzenie czterech typów pytań testowych:

- pytania jednokrotnego wyboru,

- pytania wielokrotnego wyboru,

- zestawów czterech twierdzeń ze wskazywaniem prawda-fałsz,

- pytania z uzupełnianiem luk tekstowych,

Natomiast najnowsza wersja standardu: QTI 2.1 definiuje aż 19 wzorców budowy pytań testowych. Do najważniejszych należą2:

- selecting one or more items from a list (wybór poprawnych odpowiedzi: jednej lub wielu),

- putting a list of items into a specified order (uporządkowanie listy odpowiedzi),

- creating associations between items in a list (wskazanie związków pomiędzy elementami listy),

- creating pairings between items in two lists (wskazanie związków pomiędzy elementami dwóch list),

- selecting items from lists to fill gaps in text (wybór pozycji z listy w celu wypełnienia luk w tekście)

- text entry (wpisanie odpowiedzi w okienko tekstowe),

- making one or more selections of text from a longer passage (hot text) (wybór właściwych fragmentów tekstu),

- selecting one or more areas from an image (hotspot) (wybór właściwych fragmentów obrazu),

- selecting one or more points from an image (wskazanie punktów na obrazie),

- imposing order on a set of defined areas of an image (ustalanie kolejności fragmentów obrazu),

- creating associations between a set of defined areas of an image (wskazanie związków pomiędzy pokazanymi fragmentami obrazu)

- filling gaps in an image (wypełnianie luk w obrazach),

- slider (wybór wartości numerycznej z danego przedziału suwakiem graficznym),

- editing an image (edycja obrazu).

Oba standardy reprezentują bogactwo dobrze przemyślanych metodologii testowania wiedzy studenta. Starszy z nich jest szeroko stosowany w narzędziach edukacji zdalnej, nowszy wyróżnia się możliwościami lepszego dostosowania do specyfiki danej dziedziny wiedzy oraz wyboru interfejsu odpowiedzi adekwatnego do wieku egzaminowanego. Z technicznego punktu widzenia różnice w standardach polegają na odmiennej organizacji przechowywania pytań w pamięci dyskowej. W QTI 1.2 tworzony jest jeden plik dla wszystkich pytań testu, podczas gdy w standardzie 2.1 pojedyncze pytanie zapisywane jest w odrębnym pliku. Standard QTI 2.1 zakłada budowę centralnej bazy pytań dostępnych za pośrednictwem sieci do wspólnego wykorzystywania przez wielu autorów (np. z wielu uczelni). Jest to istotne usprawnienie organizacyjne w porównaniu z wersją QTI 1.2. Egzaminowany student zauważy z kolei różnicę polegającą na wzbogaceniu interfejsu testu.

Stosowanie standardów umożliwia wymianę zasobów egzaminacyjnych między różnymi placówkami edukacyjnymi, co pozwala skrócić czas tworzenia dużych baz pytań testowych. Jest faktem powszechnie znanym, że budowa takiej bazy to proces bardzo czasochłonny, zwłaszcza jeśli pytania zawierają elementy multimedialne (grafikę, dźwięk, filmy, wzory chemiczne lub matematyczne). Możliwość wymiany baz egzaminacyjnych wraz z ich multimedialną zawartością między różnymi aplikacjami, np. portalami e-learningowymi, jest bezcennym i oczekiwanym przez uczelnie udogodnieniem w procesie ewaluacji wiedzy studenta.

Metodologie testowania wiedzy

Metodologia testowania to jeden z ważniejszych elementów w procesie sprawdzania wiedzy studenta. Różne metody logicznej organizacji odpowiedzi na pytania w istotny sposób wpływają na prawdopodobieństwo wskazania poprawnej odpowiedzi drogą losowania. Wybór metodologii testowania oraz progu umożliwiającego zaliczenie testu nie powinien być intuicyjny - należy przeprowadzić kalkulację i ocenić wspomniane prawdopodobieństwo losowego uzyskania wyniku zaliczającego3.

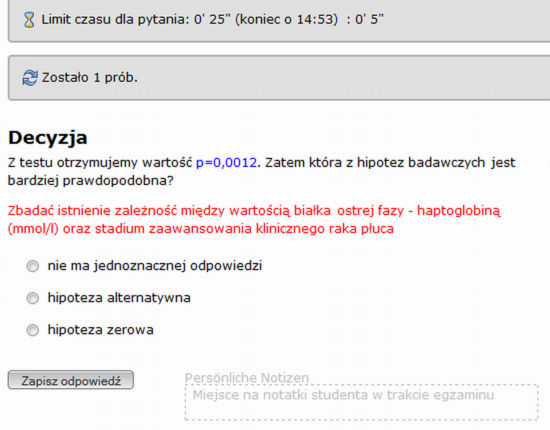

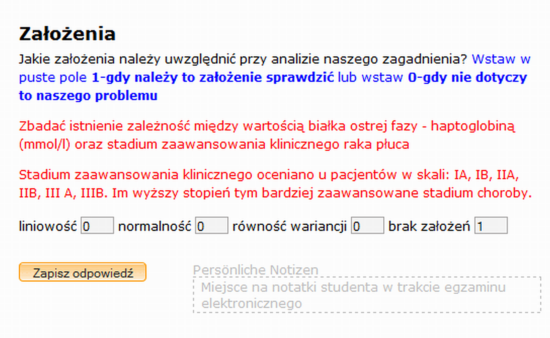

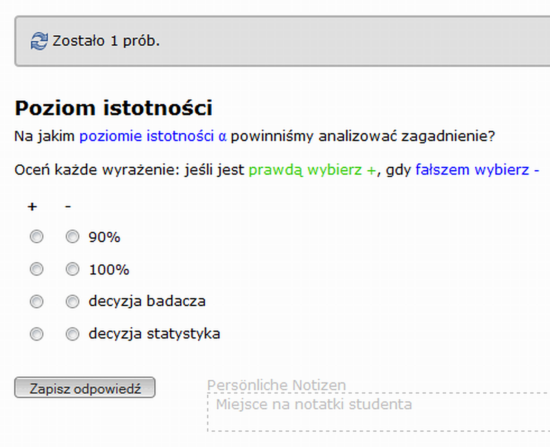

Autorzy artykułu testowali wiedzę studentów medycyny ze statystyki w oparciu o pytania bazujące na różnej logice organizacji odpowiedzi. Podczas egzaminu wykorzystano wszystkie typy pytań dostępne w standardzie QTI 1.2 :

- pytania jednokrotnego wyboru z dowolną liczbą (3-5) wariantów odpowiedzi (rysunek 1),

- pytania wielokrotnego wyboru z dowolną liczbą (3-5) wariantów odpowiedzi (rysunek 2),

- pytania z uzupełnianiem luk w tekście (rysunek 3),

- pytania typu prawda-fałsz (rysunek 4).

Pytania typu prawda-fałsz są pewną odmianą pytań jednokrotnego wyboru, ale z innym prawdopodobieństwem losowego uzyskania poprawnego wyniku.

Tworząc egzamin testowy, wykładowcy najchętniej wybierają pytania jednokrotnego wyboru ze stałą liczbą wariantów odpowiedzi. Ustalenie progu zaliczenia wynoszącego 50 proc. liczby pytań oznacza, że test będzie łatwy. Natomiast próg zaliczenia wyższy niż 50 proc. daje test trudny do zaliczenia przez losowy wybór odpowiedzi. W przypadku testów z pytaniami wielokrotnego wyboru losowe przekroczenie progu zaliczenia jest bardzo mało prawdopodobne. Zatem sensowne wydaje się budowanie testów zaliczeniowych i egzaminacyjnych w oparciu o pytania wykorzystujące różne metodologie testowania wiedzy.

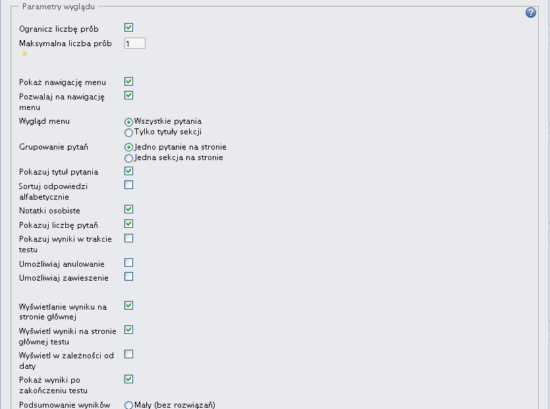

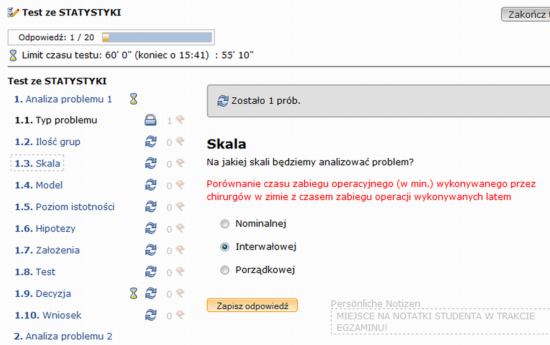

Sterowanie przebiegiem egzaminu za pomocą wartości parametrów

W przypadku elektronicznego egzaminu oprócz właściwej metodologii testowania ważny jest także właściwy dobór parametrów dla pytań egzaminacyjnych oraz całego testu. Decyduje to o przebiegu egzaminu oraz jego wyglądzie na ekranie monitora, co z kolei ma wpływ na komfort pracy studenta podczas zaliczenia. Parametry całego testu gwarantują przebieg egzaminu zgodny z intencją prowadzącego przedmiot (rysunek 5). Należy zawsze sprawdzić, czy implementacja standardu QTI na portalu LCMS, na którym prowadzimy testowanie, w pełni realizuje standard.

Parametryzacja pytań testowych dotyczy:

- czasu odpowiedzi na pojedyncze pytanie,

- losowej kolejności odpowiedzi na pytanie,

- liczby dopuszczalnych prób udzielenia odpowiedzi na pytanie,

- sposobu prezentacji pytania i odpowiedzi na ekranie komputera,

- uwidaczniania studentowi poprawnej odpowiedzi na pytanie,

- uwidaczniania komentarza/podpowiedzi do pytania.

Parametryzacja testu dotyczy:

- czasu wypełniania testu,

- czasu udzielania odpowiedzi dla grupy pytań, losowania kolejności pytań w obrębie grupy,

- uwidocznienia zegara czasu,

- uwidocznienia aktualnego wyniku testu,

- uwidocznienia liczby pytań,

- liczby dopuszczalnych prób uruchomienia testu,

- sposobu prezentacji całego testu, np. dostępności menu testu, widoczności grupy pytań,

- uwidaczniania komentarza do testu.

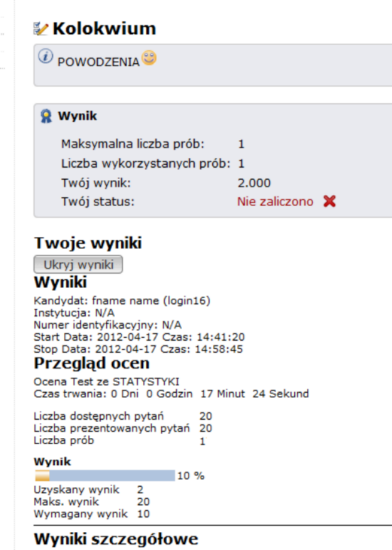

Możliwe są różne formy prezentacji wyników testu po jego zakończeniu np. krótka informacja o wyniku testu (rysunek 6)

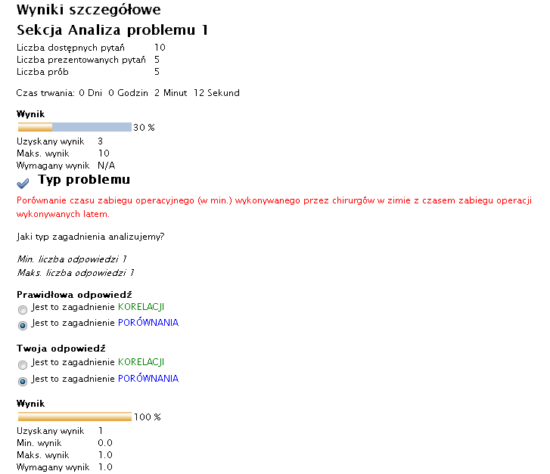

lub jego bardziej szczegółowe omówienie (rysunek 7) wraz z podaniem poprawnych odpowiedzi na poszczególne pytania. Jest to szczególnie ważne w przypadku testów powtórkowych oraz testów, za pomocą których student może samodzielnie sprawdzić swoje postępy w trakcie nauki.

Niezależnie od sposobu uwidocznienia wyników standard przewiduje spersonalizowany dla każdego studenta raport z testu zawierający: treść pytania, poprawną odpowiedź, udzieloną odpowiedź oraz analizę wyników w procentach dla testu i każdego pytania. Taki zestaw informacji jest dla każdego studenta archiwizowany w zasobach serwera edukacji zdalnej.

Ewaluacja wiedzy z przedmiotu biostatystyka

Praktyczny egzamin z przedmiotu biostatystyka dla studentów IV roku medycyny (n=24) Uniwersytetu Medycznego w Poznaniu w roku akademickim 20112012 polegał na analizie trzech statystycznych problemów badawczych losowanych z bazy uwzględniającej metodologiczny podział zagadnień. Egzamin trwał 60 minut i przeprowadzony był w sali komputerowej uczelni. Przyswojenie przez studentów zagadnień dotyczących dwóch pierwszych problemów sprawdzano testem zamkniętym (rysunek 8).

Rozwiązanie problemu trzeciego, który był sformułowany w postaci zadania otwartego, studenci przekazywali do zasobów portalu LCMS w celu sprawdzenia go przez wykładowcę. W części testowej wykorzystano cztery typy pytań (opisane w części Metodologie testowania wiedzy), dostosowane do etapu analizy statystycznej problemu. Czas rozwiązania każdego z problemów był ograniczony do 20 minut. Na rozwiązanie problemu badawczego w formie testu składały się odpowiedzi na 10 pytań szczegółowych (od 1.1 do 1.10 - rysunek 8). Pytania pojawiały się w ustalonej kolejności wraz z tytułami definiującymi etap analizy statystycznej. Kolejność odpowiedzi była losowa. Czas przeznaczony na każde z pytań szczegółowych był ograniczony (rysunek 1). Na wybrane pytania szczegółowe można było udzielić odpowiedzi dwukrotnie, a w pozostałych przypadkach była tylko jedna możliwość jej zapisu. Test mógł być uruchomiony przez studentów tylko raz. Po jego zakończeniu student widział:

- wymagany próg zaliczeniowy dla tej części egzaminacyjnej,

- liczbę zdobytych punktów wraz z zapisem procentowym,

- informację, czy zaliczył część testową, czy też nie.

Na ocenę z egzaminu składały się dwa elementy: wynik z części testowej (znany studentom od razu po zakończeniu testu) oraz ocena za zadanie otwarte. Wynik końcowy z egzaminu obliczany był automatycznie na platformie e-learningowej po wprowadzeniu przez wykładowcę oceny za zadanie otwarte.

Budowa baz egzaminacyjnych

Przy zastosowaniu mechanizmu losowania pytań i kolejności prezentowania wariantów odpowiedzi student otrzymuje za każdym razem inny zestaw zadań. Mechanizm losowania przewidziany jest dla grup pytań (zob. Sterowanie przebiegiem egzaminu za pomocą wartości parametrów) - w standardzie QTI nie zaprojektowano losowania samych grup. Oznacza to, że test z pytaniami podzielonymi na trzy grupy (przykładowo) zawierać będzie zawsze co najmniej jedno pytanie z każdej z nich. Problem pojawia się wtedy, gdy chcemy, aby test zawierał pytania wyłącznie z dwóch grup pytań, a z trzeciej nie. Rozwiązanie tego problemu polega na zorganizowaniu pytań w oddzielne pliki dla każdej z grup i podzieleniu egzaminu na testy cząstkowe. Dostępne są mechanizmy automatycznego sumowania wyników z takiego egzaminu. Innym, bardziej pracochłonnym rozwiązaniem jest budowa bazy pytań wymagająca edycji plików testów zapisywanych w formacie XML.

Opinie studentów po elektronicznym egzaminie

Ewaluacja wiedzy statystycznej była pilotażowym etapem wdrożenia elektronicznej formy egzaminowania z przedmiotu biostatystyka prowadzonego w formie tradycyjnej. Materiały egzaminacyjne zaplanowano i opracowano w taki sposób, aby mogły zostać wykorzystane również jako materiał powtórkowy przed zaliczeniem lub jako testy przydatne w samodzielnej pracy studenta.

Po egzaminie dokonano wspólnie ze studentami analizy formy przeprowadzonego zaliczenia. Tabela 2 zawiera zestawienie istotnych dla studentów cech elektronicznej ewaluacji wiedzy dotyczących jej przebiegu oraz formy prezentacji pytań testu. Kolejność podanych określeń została ustalona na podstawie liczby ich wystąpień w ankietach (ranking malejący).

| Istotne dla studentów cechy elektronicznego egzaminowania | Proc. studentów |

| Znany od razu wynik testu | 84% |

| Czytelny spis pytań i odpowiedzi w teście | 84% |

| Czas egzaminu liczony każdemu zdającemu indywidualnie | 80% |

| Jednakowa ilość czasu mierzona przez komputer | 72% |

| Monitorowanie liczby pytań, na które trzeba udzielić odpowiedzi | 68% |

| Możliwość poznania prawidłowych odpowiedzi wraz z komentarzem (bardzo istotne przy testach wykonywanych samodzielnie) | 68% |

| Możliwość wyboru kolejności udzielania odpowiedzi | 56% |

| Losowy dobór pytań i odpowiedzi gwarantujący obiektywność oceny z testu | 44% |

| Możliwość dodawania notatek przy pytaniach | 36% |

| Indywidualny zestaw pytań egzaminu gwarantujący samodzielne rozwiązanie testu przez studenta | 36% |

Źródło: opracowanie własne

Studenci (19 ankietowanych) chętnie wprowadziliby elektroniczną formę egzaminowania także na innych przedmiotach. Ich zdaniem (13 repondentów) wykładowcy powinni częściej stosować tę formę egzaminowania na zaliczeniach cząstkowych lub podczas bieżącego sprawdzenia teoretycznego przygotowania studentów do zajęć. Nie życzą sobie natomiast uwidaczniania aktualnego wyniku testu w trakcie trwania egzaminu (16 ankietowanych). Pytania z ograniczonym czasem na odpowiedź działają na nich stresująco (8 respondentów), tak więc autorzy uważają, iż stosowanie tego rozwiązania powinno być dokładnie przemyślane należy je wykorzystywać głównie w pytaniach wymagających szybkiego podjęcia decyzji (np. dotyczących podania leku).

Wysoko oceniony przez studentów fakt otrzymywania natychmiastowej informacji o wyniku testu jest również bardzo istotnym elementem dla nauczyciela (egzaminatora), który nie musi poświęcać czasu na sprawdzanie prac, tworzenie list z wynikami oraz rozsyłanie ich do studentów. Ten etap realizowany jest przez mechanizmy platformy LCMS. Dwa istotne elementy procesu elektronicznego egzaminowania losowy dobór pytań i kolejności odpowiedzi wewnątrz pytania testu oraz mierzenie czasu trwania egzaminu automatycznie przez komputer zdaniem studentów gwarantują takie same warunki przebiegu egzaminu wszystkim zdającym. Każdy wykładowca akademicki wie, jak trudno spełnić te wymagania podczas egzaminu w tradycyjnej formie. W odczuciach studentów test sprawdzany przez komputer zapewnia bezstronność oceny i minimalizuje liczbę możliwych pomyłek.

Podsumowanie

Kwestią nadrzędną dla organizacji elektronicznego egzaminu jest odpowiednia budowa materiałów egzaminacyjnych oraz zastosowanie międzyplatformowego standardu QTI realizowanego przez API5 portalu LCMS. Prezentowany w artykule standard Question and Test Interoperability gwarantuje właściwą metodykę przeprowadzania egzaminu oraz możliwość wymiany zbudowanej bazy egzaminacyjnej między placówkami edukacyjnymi. Stosowanie standardów umożliwia również lokalne tworzenie pytań poza konkretną platformą edukacyjną.

Element ewaluacji wiedzy studenta, raz dobrze przemyślany i zrealizowany przez zespół prowadzącego przedmiot, będzie przez kilka lat działał bezobsługowo. Oczywiście z upływem czasu i pojawianiem się nowych zagadnień merytorycznych będzie wymagał aktualizacji, ale to zagadnienie sprowadza się już tylko do modyfikacji posiadanych baz pytań.

Bibliografia

- M. Kotowski, Quiz z importu, "e-mentor" 2007, nr 4 (21).

- A. Ren-Kurc, M. Roszak, Ewaluacja procesu dydaktycznego. Organizacja egzaminów testowych i ankietowania, [w:] J. Migdałek, A. Stolińska (red.), Technologie Informacyjne w Warsztacie Nauczyciela, Nowe wyzwania edukacyjne implikowane rozwojem technologii informacyjnej, Wydawnictwo Naukowe Uniwersytetu Pedagogicznego w Krakowie, Kraków 2011.

- M. Roszak, B. Kołodziejczak, E-ewaluacja wiedzy statystycznej studentów medycyny, Kongres Statystyki Polskiej z okazji jubileuszu 100-lecia Polskiego Towarzystwa Statystycznego, Streszczenia referatów, Poznań 2012.

- G. Wills i in., Delivery of QTIv2 Question Types, materiały International CAA Conference, 10-11.07.2007, Loughborough, Wielka Brytania.

Netografia

- I. Gutiérrez Rojas, Á. Agea, R. M. Crespo, A. Pardo, D. Leony, C. Delgado Kloos, Assessment interoperability using QTI, Conference ICL2009, 23-25.09.2009, Villach, Austria, http://www.icl-conference.org/dl/proceedings/2009/program/pdf/Contribution_144.pdf .

- D. Helic, Template-based Approach to Development of Interactive Tests with IMS Question & Test Interoperability, http://coronet.iicm.tugraz.at/denis/pubs/edmedia06a.pdf.

- IMS Question and Test Interoperability v.2.1 Final Specification, http://www.imsglobal.org/question/index.html#version2.1

- IMS Question and Test Interoperability v.1.2 Final Specification HTML, http://www.imsglobal.org/question/index.html#version1.2

- M. Roszak, A. Ren-Kurc, W. Kowalewski, K. Nowakowski, Standardy e-ewaluacji procesu dydaktycznego. Question & Test Interoperability, X Konferencja Wirtualny Uniwersytet, model, narzędzia, praktyka, 1618.06.2010, SGGW Warszawa, http://vu2010.sggw.pl/data/downloads/Standardy%20e-ewaluacji%20procesu%20dydaktycznego.pdf.

- Przykłady zastosowań standardu QTI 2.1 do budowy pytań testowych, https://www2.ph.ed.ac.uk/qtiworks/web/anonymous/samples/list.